近日,西北工业大学高超教授团队在人工智能情感计算领域取得重要进展。团队针对多模态情感分析中的跨模态冲突、冗余以及对话情感识别中的隐式关系建模等挑战实现技术突破。相关成果分别以“DDSE: A Decoupled Dual-Stream Enhanced Framework for Multimodal Sentiment Analysis with Text-Centric SSM”和“Hybrid Relational Graphs with Sentiment-laden Semantic Alignment for Multimodal Emotion Recognition in Conversation”为题发表在多媒体领域顶级国际会议ACM MM 2025(ACM International Conference on Multimedia)和人工智能领域顶级国际会议IJCAI 2025(International Joint Conference on Artificial Intelligence)(均为CCF A类会议)上。上述两项工作均得到国家自然科学基金、陕西省科技创新团队等项目资助。

基于文本中心状态空间模型的解耦双流增强多模态情感分析框架

多模态情感分析(MSA)旨在通过融合文本、音频和视觉信号来识别人的情感极性和强度。然而,现有的单步融合策略容易产生模态间的表示冲突,且往往忽视了文本模态在高级潜在融合空间中的主导作用,导致关键的情感线索被冗余信息淹没。

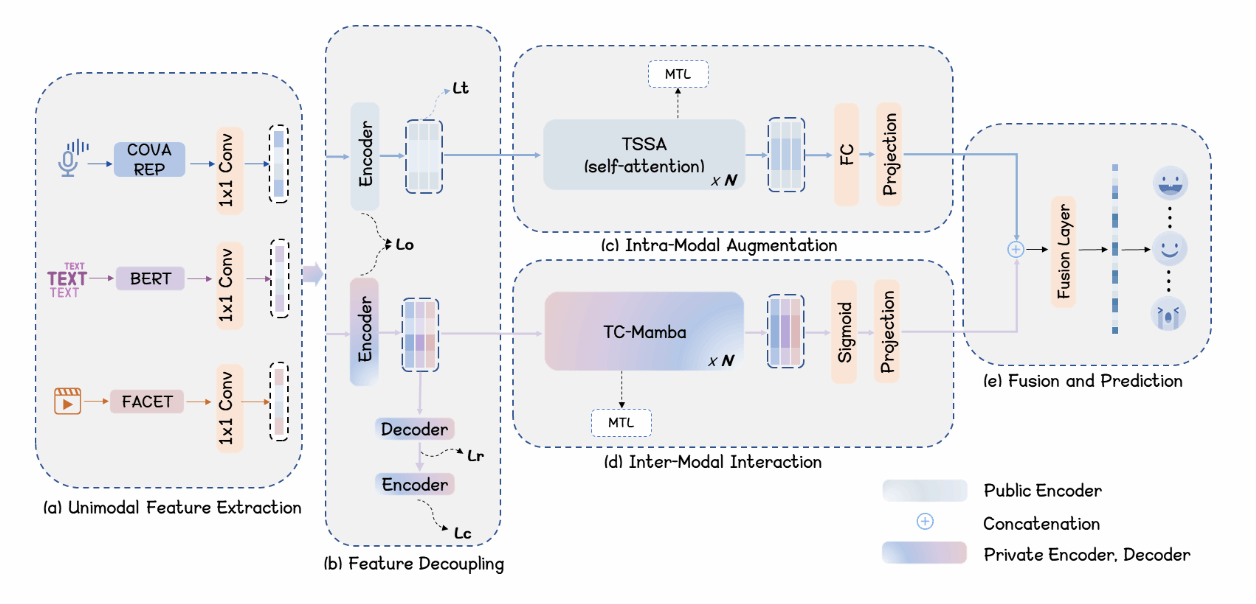

针对此,研究团队提出了解耦双流增强框架DDSE,创新性地引入“以文本为中心的状态空间模型(TC-Mamba)”。该框架设计了特征解耦机制以区分公共与私有表示,并利用以文本为核心的渐进式交互策略引导多模态融合,在有效保留关键情感线索的同时大幅降低了信息冗余。在MOSI和MOSEI等主流数据集上的实验表明,DDSE在情感分类精度及推理效率上均显著优于现有的Transformer类方法,实现了性能与资源消耗的最佳平衡。该研究有效解决了多模态数据间的异构性与干扰问题,为多模情感理解的高效化应用提供了重要参考。

图1:DDSE算法框架图

西北工业大学光电与智能研究院博士生姜慎杰为论文第一作者,高超教授为论文通讯作者。

论文代码链接:https://github.com/cgao-comp/DDSE。

融合情感语义对齐与混合关系图的多模态对话情感识别

对话中的多模态情感识别(MERC)需要识别说话人在每一轮对话中的情感状态。现有的基于图的方法多关注显式的对话者关系,却忽视了模态内部的隐式关联、跨模态隐式关系的差异,以及对话历史中情感标签所蕴含的语义价值。

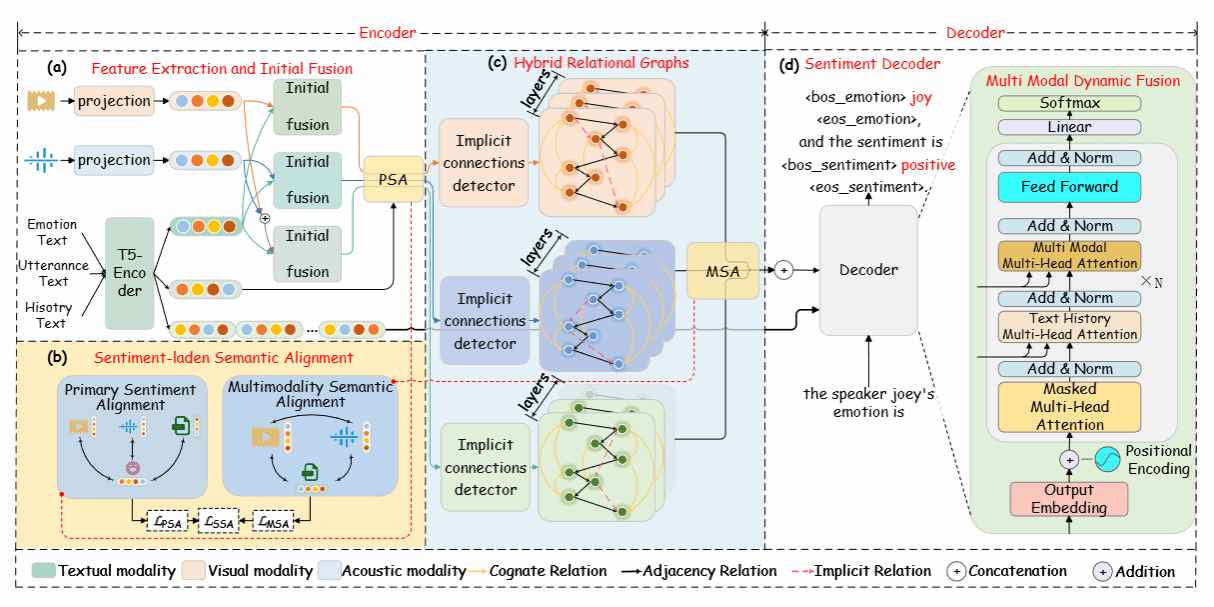

为此,研究团队提出了一种结合混合关系图(HRG)与情感语义对齐策略(SSA)的端到端生成框架HRG-SSA。该框架将MERC任务转化为文本生成任务,使对话历史中的情感标签具备真实的文本情感语义。SSA策略通过两阶段对比学习,将各模态特征与情感语义进行对齐,强化了模型对情感线索的提取能力。同时,HRG模块通过模态自适应的连接预测机制挖掘模态内的隐式关系,构建了更全面的对话图结构,提升了模态内与模态间的特征融合效果。实验证明,HRG-SSA在IEMOCAP和MELD数据集上的性能优于现有主流方法,能够更准确地捕捉对话中的细微情感波动。

图2:HRG-SSA算法框架图

西北工业大学光电与智能研究院博士生姬宏儒为论文第一作者,高超教授为论文通讯作者。

论文代码链接:https://github.com/cgao-comp/HRG-SSA。

(文:姜慎杰,审核:赵斌)

搜索

搜索  英文

英文  联系我们

联系我们  首页

首页