近日,西北工业大学王琦教授团队在深度学习高效训练领域取得重要突破,相关研究论文《Inconsistency Biases In Dynamic Data Pruning》被人工智能领域顶级国际会议 ICLR (International Conference on Learning Representations)2026录用。

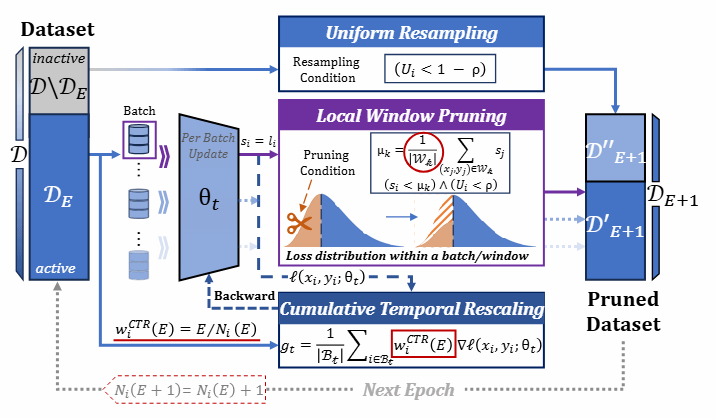

针对深度学习模型在海量数据训练中面临的高昂计算成本问题,本研究创新性地提出了RePB(Resolving Pruning Biases)框架,旨在通过科学的数据选择实现训练加速。该框架系统性地解决了动态数据剪枝中长期存在的两大一致性难题:一是通过局部窗口剪枝(Local Window Pruning, LWP)机制,在模型状态相对稳定的短周期内进行重要性评分对比,有效克服了因参数漂移导致的“评分背景漂移”;二是结合累积时间重标定(Cumulative Temporal Rescaling, CTR)技术,根据样本的历史选择频率动态调整梯度权重,从理论和实践层面纠正了“时间梯度偏差”,确保了剪枝后的训练轨迹与全量数据训练保持一致。

在涵盖图像分类、视觉语言理解、图像生成等13项主流任务和16个数据集的广泛实验中,RePB展示了卓越的通用性与性能。在ResNet、ViT及Mamba等17种主流模型架构上,RePB均能在剔除30%至50%训练数据的前提下,维持甚至超越全量数据集的训练精度。值得一提的是,该算法自身的计算开销极低,仅占整体训练时间的0.004%至0.011%,实现了真正的绿色高效训练。本研究通过对动态剪枝一致性偏差的深入分析与修复,为实现更高效、稳定的深度学习模型训练提供了有益的探索方向。

论文第一作者为西北工业大学光电与智能研究院博士生周情,通讯作者为王琦教授。

(文:周情,审核:赵斌)

搜索

搜索  英文

英文  联系我们

联系我们  首页

首页